Einleitung & Anforderungen

Da viele meiner beruflichen Projekte KI - primär Claude und OpenAI - auch für Coding-Aufgaben nutzen habe ich mir in den letzten Tagen die Frage gestellt, ob und wie KI lokal (auf meinem PC bzw. im lokalen Netzwerk) ausgeführt und dennoch sinnvoll in Entwicklungsprojekte eingebunden werden kann.

Meine Anforderungen bestehen im Grunde aus drei Punkten:

- Das KI-Modell soll lokal ausgeführt werden und ohne Internet- bzw. Cloud-Anbindung laufen.

- Das KI-Modell soll in Visual Studio Code integriert werden können und folgende Features bieten:

- Code erklären (“explain code”)

- Code bearbeiten

- Code-Autovervollständigung (“code suggestions”)

- Werkzeugverwendung (“tool usage”) um zum Beispiel Model Context Protocol (MCP) Server anzubinden

- Das bzw. die KI-Modell(e) sollen einfach austauschbar bzw. aktualisierbar sein.

Ziel dieses Artikels ist es, die Grundlagen für die praktische Anwendung von lokalen KI-Modellen mit Ollama und die Integration in VS Code zu zeigen.

Grundlagen - Was ist Ollama und warum ist es nützlich?

Was ist Ollama?

Vereinfacht gesagt ist Ollama eine App, um KI-Modelle auf einem lokalen Gerät ohne Abhängigkeit zu einem Cloud-Anbieter auszuführen. Es ist für Linux, Mac und Windows verfügbar und kann über alle gängigen Paketmanager installiert werden. Ollama unterstützt alle bekannten LLMs und erlaubt es zusätzlich, diese via Modelfiles anzupassen.

Warum lokale Modelle nutzen?

Meine Hauptgrund ist Datenschutz und sollte sich fast von selbst erklären: die von lokal laufende KI-Modellen verarbeiteten Daten landen nicht auf den Servern von Cloud-Anbieter.

Zusätzlich experimentiere ich mit verschiedenen Modellen und möchte nicht für jeden anbieter ein Abonnement mit monatlichen Kosten abschließen.

Alternativen zu Ollama

Neben Ollama gib es natürlich auch noch andere Lösungen, um KI-Modelle lokal zu betreiben. Die bekanntesten sind LocalAI und LM Studio.

Installation und Einrichtung

Achtung: Ein KI-Modell lokal auf deinem PC zu betreiben erfordert entsprechende Hardware-Ressourcen. 16 GB Arbeitsspeicher (RAM) und eine aktuelle Grafikkarte (GPU) mit zumindest 8 GB VRAM für keine Modelle sollten es mindestens sein; entsprechend mehr für größere Modelle.

Installation von Ollama

Ollama kann einfach via Packetmanager installiert werden. Unter Mac via Homebrew…

brew install ollama… unter Windows via WinGet…

winget install -e Ollama.Ollama… und sollte anschließend mit ollama --version die aktuelle Version ausgeben.

Modell herunterladen und ausführen

Anschließend in der Ollama Library ein passendes Modell auswählen und den “Modell-Identifier” kopieren. Ich nutze aktuell folgende Modelle:

- qwen3-coder: die 30b Variante (

qwen3-coder:30b) läuft auf meiner Hardware zufriedenstellend und eignet sich durch das großzügige Contextwindow (256K) für größere Projekte. - devstral-small-2 is ein neues Modell von Mistral AI und in der ‘small’ Variante mit 24b (

devstral-small-2:24b) sehr effizient im Coden. - gemma3: die ‘kleine Schwester’ von Googles Gemini ist insbesondere in der 12b QAT-Variante (quantization aware trained;

gemma3:12b-it-qat) ein sehr effizientes Reasoning-Modell.

Mit dem entsprechenden “Modell-Identifier” können wir Ollama anweisen, das Modell herunterzuladen…

ollama pull gemma3:12b-it-qat… bzw. auch gleich interaktiv auszuführen:

ollama run gemma3:12b-it-qatVS Code und Copilot Chat Extension Installation

Visual Studio Code lässt sich ebenfalls einfach via Packetmanager installieren. Unter Mac via Homebrew…

brew install --cask visual-studio-code… unter Windows via WinGet…

winget install -e Microsoft.VisualStudioCode… und sollte anschließend mit code -v die aktuelle Version ausgeben.

Zusätzlich benötigen wir noch die “GitHub Copilot Chat” Extension als Interface zwischen VS Code und unserem Ollama KI-Modell. Wir können sie einfach mit folgendem Befehl installieren:

code --install-extension github.copilot-chatMicrosoft Azure MCP Server

Der Azure MCP Server kann entweder standalone mit einem Packetmanager oder als VS Code Extension installiert werden. Da wir ohnehin VS Code nutzen können wir uns die Arbeit etwas erleichtern und direkt die Extension installieren:

code --install-extension ms-azuretools.vscode-azure-mcp-serverAchtung, der Azure MCP Server benötigt das .NET 10 SDK!

Praktische Anwendung - Ollama und VS Code im Zusammenspiel

Modellauswahl in Copilot Chat

Zuerst prüfen wir mit ollama list, ob die von uns heruntergeladenen KI-Modelle in Ollama verfügbar sind:

ollama list

NAME ID SIZE MODIFIED

qwen3-coder:30b 06c1097efce0 18 GB 2 hours ago

gemma3:12b-it-qat 5d4fa005e7bb 8.9 GB 6 hours ago

devstral-small-2:latest 24277f07f62d 15 GB 2 days agoFehlt ein Modell, dann kann es mit ollama pull <model-identifier> heruntergeladen werden. Sind alle gewünschten Modelle in Ollama vorhanden, dann starten wir VS Code und wechseln in die Copilot Chat Modellkonfiguration - entweder via Ctrl-Shift-P > Chat: Manage Language Models oder über das Modellauswahl-Dropdown in der Chat GUI:

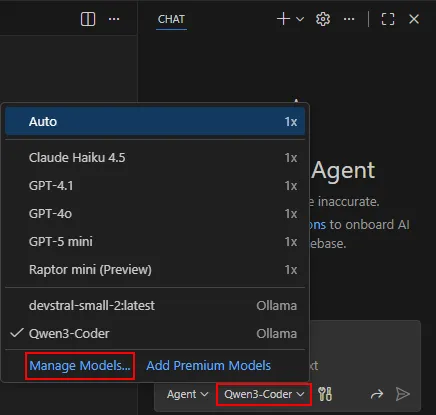

Abbildung 1: Copilot Chat Modellauswahl

Abbildung 1: Copilot Chat Modellauswahl

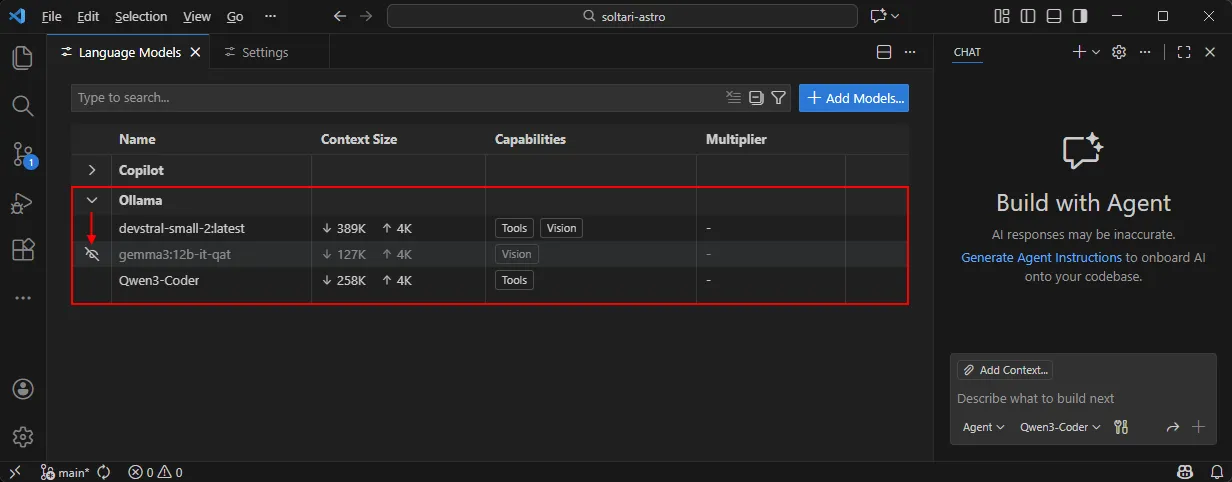

In der Modellauswahl listet VS Code automatisch alle Modelle, welche in Ollama verfügbar sind auf. Mit dem “Einblenden/Ausblenden” Icon links neben dem Modellnamen wird gesteuert, ob es im Copilot Chat zur Auswahl steht:

Abbildung 2: Copilot Chat Modellkonfiguration

Abbildung 2: Copilot Chat Modellkonfiguration

Werden die Modelle in der Modellauswahl (vgl. Abb. 1) aufgelistet, so sind sie für Copilot Chat verfügbar.

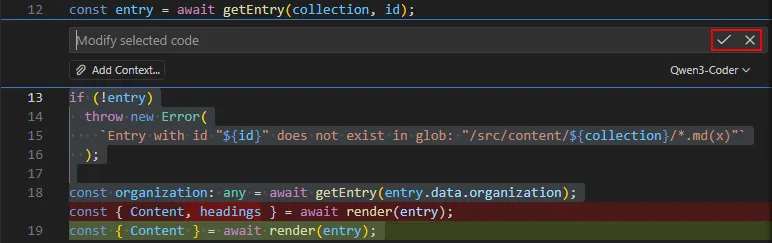

Code-debugging und Fragen

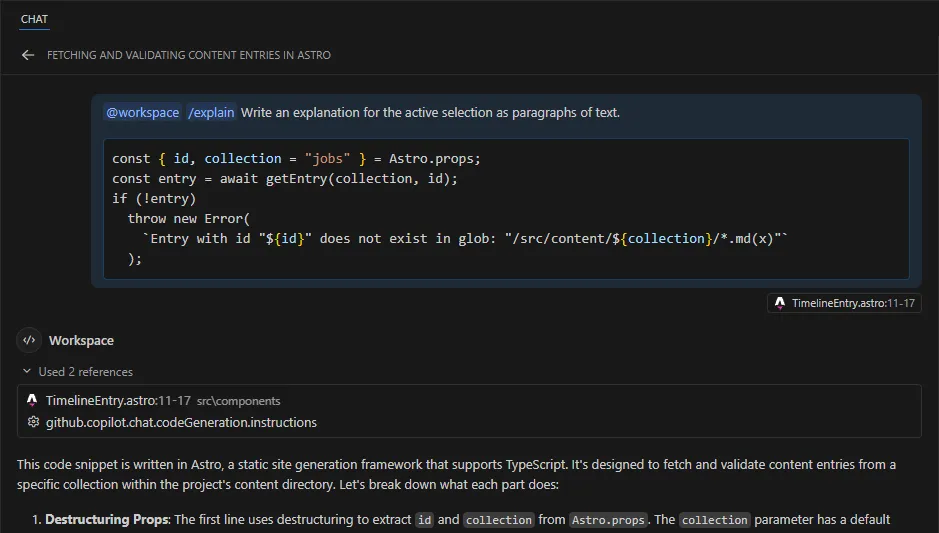

Um eine Codestelle von unserem KI-Modell erklären zu lassen einfach den entsprechenden Code markieren und mit Ctrl-Shift-P > Chat: Explain (oder Rechtsklick > Explain) den Vorgang starten. VS Code gibt die markierte Codestelle automatisch als “Kontext” mit. Die Ausführung des KI-Modells landet im Chat-Fenster:

Abbildung 3: Explain Code

Abbildung 3: Explain Code

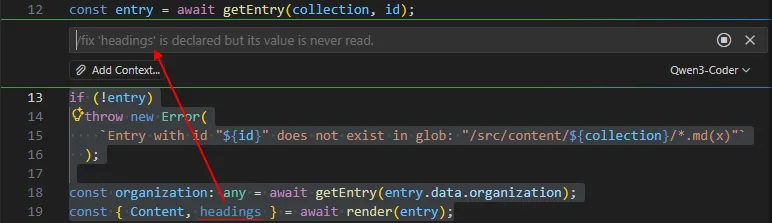

Mit Ctrl-Shift-P > Chat: Review kann eine interaktive “Code-Review” gestartet werden, und Ctrl-Shift-P > Chat: Fix startet eine KI-Debugging-Session. Hier übergibt VS Code automatisch alle erkannten Warnings und Errors als “Kontext” an das KI-Modell:

Abbildung 4: Fix Code

Abbildung 4: Fix Code

Das KI-Modell erstellt einen Code-Vorschlag, zeigt die Änderungen “inline” an und wartet auf Bestätigung:

Abbildung 5: Fix Code bestätigen

Abbildung 5: Fix Code bestätigen

An dieser Stelle noch eine wichtige Warnung: KI-generierter Code kann und wird(!) Fehler enthalten. Prüfe generierten Code daher eingehend und verwende keinen Code in Produktion welchen du nicht verstehst!

Code-suggestions & Autovervollständigung

Zum derzeitigen Zeitpunkt (Dezember 2025) gibt es noch keine Möglichkeit, die VS Code inline suggestions mit einem lokalen KI-Modell zu verbinden:

Currently, you cannot connect to a local model for inline suggestions. VS Code provides an extension API InlineCompletionItemProvider that enables extensions to contribute a custom completion provider. You can get started with our Inline Completions sample.

Dieser Artikel wird aktualisiert, sobald diese Einschränkung aufgehoben ist.

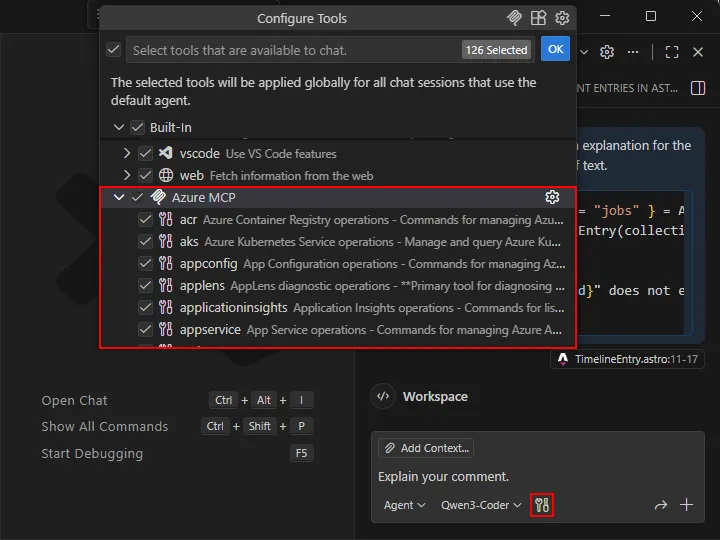

MCP-Server und Tool-Verwendung

Mit Hilfe von Model Context Protocol (MCP) Servern kann unser KI-Modell sogenannte “Tools” nutzen, um sozusagen auf Informationen bzw. System außerhalb des Copilot-Chatfensters zuzugreifen. Im folgenden Beispiel nutzen wir den Azure MCP Server, um dem KI-Modell Zugriff auf Ressourcen in Azure zu geben.

Wurde der MCP-Server wie oben beschrieben als VS Code Extension installiert, dann ist dieser bereits integriert und die Tools sollten direkt in Copilot Chat aufgelistet werden:

Abbildung 6: Azure MCP Server Tools

Abbildung 6: Azure MCP Server Tools

Um die Azure MCP Server Tools zu nutzen muss die Azure CLI einen gültigen Authentifizierungstoken besitzen. Das bedeutet, wir melden uns erst mit az login an und können unser KI-Modell anschließend anweisen, über die MCP Server Tools auf Azure-Ressourcen zuzugreifen, zum Beispiel mit dem einfachern Kommando ‘List my Azure resource groups’:

> List my Azure resource groups

I'll help you list your Azure resource groups. Let me use the appropriate Azure CLI command to retrieve this information.

❌ Ran List Resource groups - com.microsoft/azure (MCP Server)

It seems there was an issue with retrieving the subscription information. The error indicates that the subscription with the name ${AZURE_SUBSCRIPTION_ID} could not be found. This is likely because the subscription ID is not properly set in the environment.

...An dieser Stelle hat das KI-Modell festgestellt, dass das List Resource groups-Tool als Parameter eine Azure Subscription ID erwartet. Da der Azure MCP-Server zusätzlich ein Tool List Azure Subscription zur Verfügung stellt konnte die KI das Problem selbt lösen:

...

Let me first check what subscriptions are available in your Azure account:

✅ Ran List Azure Subscriptions - com.microsoft/azure (MCP Server)

Now I'll list the resource groups using the subscription ID that was found:

✅ Ran List Resource Groups - com.microsoft/azure (MCP Server)

Azure Resource Groups

Based on the Azure subscription information, I've found the following resource groups in your environment:

rg-***-tc9j - Located in germanywestcentral

rg-***-demo - Located in northeurope

...Fazit

- Ollama vereinfacht das Betreibern lokaler KI-Modelle wesentlich.

- Die Integration dieser KI-Modelle in die Visual Studio Code Entwicklungsumgebung mit Hilfe der Copilot Chat Extension fällt ebenfalls sehr leicht.

- Anbindung von MCP-Servern ermöglicht es zusätzlich, den KI-Modellen Zugriff auf Ressourcen außerhalb von VS Code zu geben und erweitert damit die Möglichkeiten maßgeblich.

- Die Einschränkung von VS Code, keine lokalen KI-Modelle für code-suggestions zu verwenden ist verwunderlich, ich gehe jedoch davon aus, dass dieses Feature in Kürze nachgereicht wird.